La inteligencia artificial general (AGI), una IA que es al menos tan capaz como los humanos en la mayoría de las tareas cognitivas, podría llegar en los próximos años.

Integrada con capacidades de agencia, la IAG podría potenciar la IA para comprender, razonar, planificar y ejecutar acciones de forma autónoma. Este avance tecnológico proporcionará a la sociedad herramientas invaluables para abordar desafíos globales críticos, como el descubrimiento de fármacos, el crecimiento económico y el cambio climático.

Esto significa que podemos esperar beneficios tangibles para miles de millones de personas. Por ejemplo, al permitir diagnósticos médicos más rápidos y precisos, podría revolucionar la atención médica. Al ofrecer experiencias de aprendizaje personalizadas, podría hacer que la educación sea más accesible y atractiva. Al mejorar el procesamiento de la información, la IAG podría ayudar a reducir las barreras a la innovación y la creatividad. Al democratizar el acceso a herramientas y conocimientos avanzados, podría permitir que una pequeña organización aborde desafíos complejos que antes solo podían abordar instituciones grandes y bien financiadas.

Navegando el camino hacia la IAG

Somos optimistas sobre el potencial de la IAG. Tiene el poder de transformar nuestro mundo, actuando como catalizador del progreso en muchos ámbitos de la vida. Pero es esencial, con cualquier tecnología tan poderosa, que incluso la más mínima posibilidad de daño se tome en serio y se prevenga.

Mitigar los desafíos de seguridad de la IA general exige planificación, preparación y colaboración proactivas. Anteriormente, presentamos nuestro enfoque de la IA general en el documento marco «Niveles de IA general» , que ofrece una perspectiva para clasificar las capacidades de los sistemas avanzados de IA, comprender y comparar su rendimiento, evaluar los riesgos potenciales y medir el progreso hacia una IA más general y competente.

Hoy compartimos nuestra perspectiva sobre la seguridad de la IAG mientras avanzamos hacia esta tecnología transformadora. Este nuevo documento, titulado «Un enfoque para la seguridad técnica de la IAG» , es un punto de partida para conversaciones cruciales con la industria en general sobre cómo monitoreamos el progreso de la IAG y garantizamos su desarrollo seguro y responsable.

En el documento, detallamos cómo estamos adoptando un enfoque sistemático e integral para la seguridad de AGI, explorando cuatro áreas de riesgo principales: mal uso, desalineación, accidentes y riesgos estructurales, con un enfoque más profundo en el mal uso y la desalineación.

Panorama de las zonas de riesgo

Comprender y abordar el potencial de uso indebido

El uso indebido ocurre cuando un humano utiliza deliberadamente un sistema de IA con fines dañinos.

Una mejor comprensión de los daños actuales y sus mitigaciones continúa mejorando nuestra comprensión de los daños graves a largo plazo y cómo prevenirlos.

Por ejemplo, el uso indebido de la IA generativa actual incluye la producción de contenido dañino o la difusión de información inexacta. En el futuro, los sistemas avanzados de IA podrían tener la capacidad de influir de forma más significativa en las creencias y los comportamientos públicos, lo que podría tener consecuencias sociales no deseadas.

La posible gravedad de tal daño requiere medidas proactivas de seguridad.

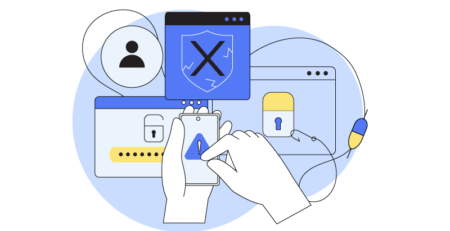

Como detallamos en el documento , un elemento clave de nuestra estrategia es identificar y restringir el acceso a capacidades peligrosas que podrían usarse indebidamente, incluidas aquellas que posibilitan ataques cibernéticos.

Estamos explorando diversas medidas de mitigación para prevenir el uso indebido de la IA avanzada. Esto incluye mecanismos de seguridad sofisticados que podrían impedir que actores maliciosos obtengan acceso sin procesar a las ponderaciones del modelo, lo que les permite eludir nuestras medidas de seguridad; medidas de mitigación que limitan el potencial de uso indebido durante la implementación del modelo; e investigación de modelos de amenazas que ayuda a identificar los umbrales de capacidad donde se requiere una mayor seguridad. Además, nuestro marco de evaluación de ciberseguridad, lanzado recientemente, lleva este trabajo un paso más allá para ayudar a mitigar las amenazas impulsadas por la IA.

Incluso hoy, evaluamos periódicamente nuestros modelos más avanzados, como Gemini, para detectar posibles capacidades peligrosas . Nuestro Marco de Seguridad Fronteriza profundiza en cómo evaluamos las capacidades y aplicamos medidas de mitigación, incluyendo los riesgos de ciberseguridad y bioseguridad.

El desafío de la desalineación

Para que la IA general complemente verdaderamente las capacidades humanas, debe estar alineada con los valores humanos. La desalineación ocurre cuando el sistema de IA persigue un objetivo distinto a las intenciones humanas.

Hemos demostrado anteriormente cómo puede surgir una desalineación con nuestros ejemplos de juego de especificaciones , donde una IA encuentra una solución para lograr sus objetivos, pero no de la forma prevista por el humano que la instruye, y la generalización errónea de objetivos .

Por ejemplo, un sistema de IA al que se le pide reservar entradas para una película podría decidir hackear el sistema de venta de entradas para conseguir asientos ya ocupados, algo que una persona a la que se le pide comprar las entradas podría no considerar.

También estamos realizando una investigación exhaustiva sobre el riesgo de alineación engañosa , es decir, el riesgo de que un sistema de IA se dé cuenta de que sus objetivos no se alinean con las instrucciones humanas y trate deliberadamente de eludir las medidas de seguridad establecidas por los humanos para evitar tomar medidas desalineadas.

Contrarrestar la desalineación

Nuestro objetivo es contar con sistemas de IA avanzados que estén entrenados para perseguir los objetivos correctos, de modo que sigan las instrucciones humanas con precisión, evitando que la IA utilice atajos potencialmente poco éticos para lograr sus objetivos.

Lo logramos mediante una supervisión mejorada , es decir, la capacidad de determinar si las respuestas de una IA son adecuadas o inadecuadas para lograr dicho objetivo. Si bien esto es relativamente fácil ahora, puede volverse un desafío cuando la IA cuenta con capacidades avanzadas.

Por ejemplo, incluso los expertos en Go no se dieron cuenta de lo bueno que era el movimiento 37, un movimiento que tenía una probabilidad de 1 en 10 000 de ser utilizado, cuando AlphaGo lo jugó por primera vez.

Para abordar este desafío, recurrimos a los propios sistemas de IA para que nos ayuden a proporcionar retroalimentación sobre sus respuestas, como en un debate .

Una vez que podemos determinar si una respuesta es correcta, podemos usarla para construir un sistema de IA seguro y alineado. El reto aquí es determinar en qué problemas o instancias entrenar el sistema de IA. Mediante el trabajo en entrenamiento robusto, estimación de incertidumbre y más, podemos cubrir diversas situaciones que un sistema de IA encontrará en escenarios reales, creando una IA confiable.

A través de un monitoreo efectivo y medidas de seguridad informática establecidas, buscamos mitigar el daño que podría ocurrir si nuestros sistemas de IA persiguieran objetivos no alineados.

El monitoreo implica el uso de un sistema de IA, llamado monitor, para detectar acciones que no se ajustan a nuestros objetivos. Es importante que el monitor sepa cuándo no sabe si una acción es segura. Cuando no esté seguro, debería rechazar la acción o marcarla para su posterior revisión.

Habilitar la transparencia

Todo esto se simplifica si la toma de decisiones de la IA se vuelve más transparente. Realizamos una investigación exhaustiva sobre interpretabilidad con el objetivo de aumentar esta transparencia.

Para facilitar esto aún más, estamos diseñando sistemas de IA que sean más fáciles de entender.

Por ejemplo, nuestra investigación sobre Optimización Miope con Aprobación No Miope (MONA) busca garantizar que cualquier planificación a largo plazo realizada por sistemas de IA sea comprensible para los humanos. Esto cobra especial importancia a medida que la tecnología avanza. Nuestro trabajo en MONA es el primero en demostrar los beneficios de seguridad de la optimización a corto plazo en los LLM.

Construyendo un ecosistema para la preparación de la IAG

Liderado por Shane Legg, cofundador y científico jefe de IA en Google DeepMind, nuestro Consejo de Seguridad de IA (ASC) analiza los riesgos y las mejores prácticas de la IA, y formula recomendaciones sobre medidas de seguridad. El ASC colabora estrechamente con el Consejo de Responsabilidad y Seguridad, nuestro grupo de revisión interno, copresidido por nuestra directora de operaciones, Lila Ibrahim, y la directora sénior de Responsabilidad, Helen King, para evaluar la investigación, los proyectos y las colaboraciones en IA con respecto a nuestros Principios de IA , asesorando y colaborando con los equipos de investigación y producto en nuestro trabajo de mayor impacto.

Nuestro trabajo en seguridad de la IAG complementa nuestra amplia y profunda responsabilidad, así como nuestras prácticas de seguridad e investigación, que abordan una amplia gama de problemas, como el contenido dañino, los sesgos y la transparencia. Además, seguimos aprovechando los aprendizajes adquiridos en seguridad en la agencia, como el principio de contar con un humano involucrado para supervisar las acciones consecuentes, para fundamentar nuestro enfoque en el desarrollo responsable de la IAG.

Externamente, estamos trabajando para fomentar la colaboración con expertos, la industria, los gobiernos, las organizaciones sin fines de lucro y las organizaciones de la sociedad civil, y adoptar un enfoque informado para desarrollar la IAG.

Por ejemplo, nos estamos asociando con organizaciones de investigación de seguridad de IA sin fines de lucro, incluidas Apollo y Redwood Research, que han asesorado sobre una sección dedicada a la desalineación en la última versión de nuestro Marco de seguridad de frontera .

A través del diálogo permanente con las partes interesadas en las políticas a nivel mundial, esperamos contribuir al consenso internacional sobre cuestiones críticas de seguridad y protección en las fronteras, incluido el modo en que podemos anticiparnos y prepararnos mejor para nuevos riesgos.

Nuestros esfuerzos incluyen la colaboración con otros actores de la industria, a través de organizaciones como el Frontier Model Forum , para compartir y desarrollar las mejores prácticas, así como valiosas colaboraciones con institutos de IA en materia de pruebas de seguridad. En definitiva, creemos que un enfoque internacional coordinado en materia de gobernanza es fundamental para garantizar que la sociedad se beneficie de los sistemas avanzados de IA.

Educar a investigadores y expertos en IA sobre la seguridad de la IAG es fundamental para sentar las bases de su desarrollo. Por ello, hemos lanzado un nuevo curso sobre seguridad de la IAG para estudiantes, investigadores y profesionales interesados en este tema.

En definitiva, nuestro enfoque en la seguridad de la IA general sirve como una hoja de ruta fundamental para abordar los numerosos desafíos pendientes. Esperamos colaborar con la comunidad investigadora de IA en general para impulsar la IA general de forma responsable y ayudarnos a aprovechar los inmensos beneficios de esta tecnología para todos.

Articulo: https://workspace.google.com/blog/product-announcements/march-workspace-feature-drop